Was ist ein Web Crawler?

Ein Web Crawler – auch bekannt als Spider, Bot oder Robot – ist ein automatisiertes Programm, welches das Internet systematisch durchsucht. Dabei besuchen sie eine Webseite, analysieren ihren Inhalt und speichern relevante Informationen in einer Datenbank, um später eine schnelle und präzise Suche zu ermöglichen. Der bekannteste Crawler ist der Googlebot, der für die Indexierung von Webseiten in der Google-Suche verantwortlich ist. Suchmaschinen wie Google oder Bing setzen Crawler ein, um das Web kontinuierlich zu erkunden und neue oder aktualisierte Inhalte in ihren Suchergebnissen bereitzustellen.

Geschichtlicher Hintergrund

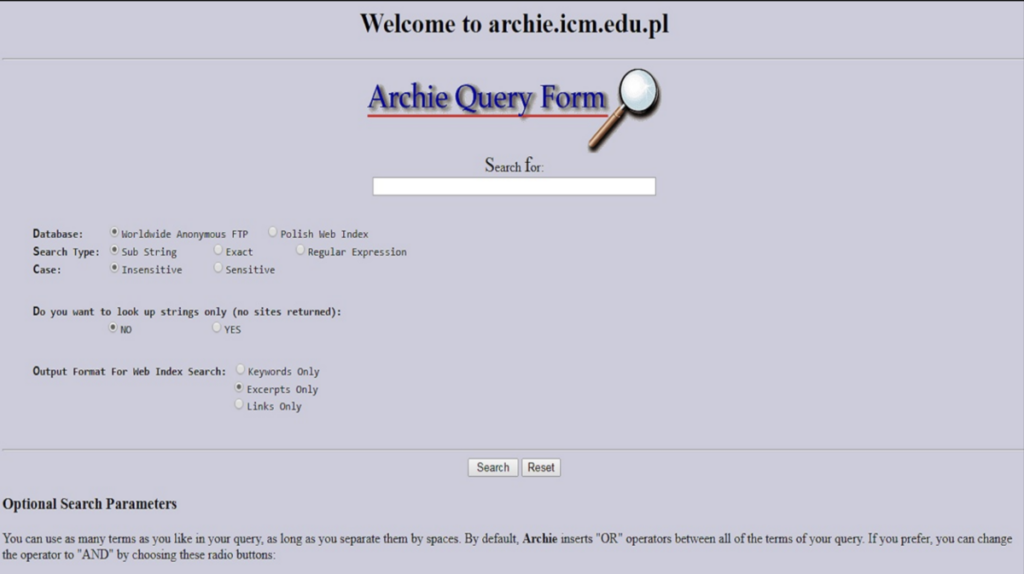

Die Geschichte der Web Crawler reicht bis in die frühen 1990er-Jahre zurück, als erste Suchmaschinen wie Archie (1990) und Gopher (1991) entstanden. Der erste richtige Web Crawler, World Wide Web Wanderer, wurde 1993 entwickelt, um das Wachstum des Internets zu messen. Kurz darauf folgte der Crawler WebCrawler (1994), der als erster Suchdienst eine vollständige Indexierung von Webseiten ermöglichte.

Mit dem Aufstieg von Google Ende der 1990er-Jahre wurde die Technologie der Web Crawler stetig weiterentwickelt. Heutige Crawler sind wesentlich effizienter und intelligenter, da sie moderne Algorithmen zur Priorisierung von Seiten, zur Erkennung von Duplicate Content und zur Berücksichtigung von Nutzerintentionen nutzen.

Funktionsweise von Web Crawlern

Web Crawler arbeiten nach einem strukturierten Verfahren, um Webseiten effizient zu durchsuchen, zu analysieren und zu indexieren. Ihre Hauptaufgabe besteht darin, Inhalte aus dem Web zu extrahieren und diese für Suchmaschinen oder andere Anwendungen verfügbar zu machen. Dabei folgen sie einem klaren Prozess, der aus mehreren Schritten besteht.

Startpunkt: Seed-URLs

Jeder Crawling-Prozess beginnt mit einer Liste von Seed-URLs, also Ausgangsseiten, die der Crawler zuerst besucht. Diese Seed-URLs können entweder von den Betreibern der Suchmaschine festgelegt oder aus früheren Crawling-Durchgängen abgeleitet werden. In der Regel handelt es sich dabei um bekannte und häufig aktualisierte Webseiten wie Nachrichtenseiten oder große Portale. Von diesen Startpunkten aus bewegt sich der Crawler durch das Web, indem er auf weitere Links innerhalb der Seiten trifft.

Verarbeitung von Hyperlinks

Sobald eine Webseite besucht wurde, analysiert der Crawler ihren HTML-Code und extrahiert alle darin enthaltenen Hyperlinks (interne und externe Links). Diese Links werden in eine Warteschlange aufgenommen und priorisiert, je nachdem, welche Relevanz die Zielseiten für die Suchmaschine haben. Faktoren wie die Autorität der verlinkenden Seite, die Anzahl der eingehenden Links oder die Aktualität des Inhalts beeinflussen, in welcher Reihenfolge Seiten aufgerufen werden.

Um unnötige Belastungen für Webseiten zu vermeiden, folgen Crawler bestimmten Regeln, die unter anderem durch die robots.txt-Datei einer Website definiert werden. Diese Datei gibt an, welche Bereiche einer Webseite gecrawlt werden dürfen und welche nicht.

Indexierung von Inhalten

Nachdem eine Seite erfolgreich gecrawlt wurde, analysiert der Crawler deren Inhalte und speichert relevante Daten in einer Datenbank. Dieser Vorgang wird als Indexierung bezeichnet. Hierbei werden verschiedene Elemente einer Seite berücksichtigt, darunter:

- Textinhalte (Überschriften, Absätze, Listen)

- Metadaten (Title-Tag, Meta Description etc.)

- Bilder und Alt-Texte

- Strukturierte Daten (Schema Markup)

Die gesammelten Informationen werden anschließend im Index der Suchmaschine abgelegt, sodass sie bei Suchanfragen in den Ergebnissen erscheinen können. Die Indexierung ist dabei nicht gleichbedeutend mit der tatsächlichen Platzierung in den Suchergebnissen – sie bildet lediglich die Grundlage für das Ranking, das durch komplexe Algorithmen der Suchmaschine bestimmt wird.

Dieser mehrstufige Prozess – Crawlen, Analysieren und Indexieren – sorgt dafür, dass Webseiten im Internet gefunden und für Nutzer zugänglich gemacht werden. Effiziente Web Crawler sind essentiell für Suchmaschinen, um aktuelle und relevante Inhalte bereitzustellen.

Arten von Web Crawlern

Web Crawler sind nicht alle gleich – je nach Einsatzzweck gibt es unterschiedliche Typen, die sich in ihrer Funktionsweise und Zielsetzung unterscheiden. Während einige Crawler speziell für Suchmaschinen arbeiten, sind andere auf bestimmte Aufgaben wie die Analyse von Webseiten oder das Sammeln von E-Mail-Adressen spezialisiert. Hier sind die wichtigsten Arten von Web Crawlern:

Suchmaschinen-Crawler (z. B. Googlebot)

Die bekanntesten und am weitesten verbreiteten Web Crawler sind diejenigen, die von Suchmaschinen wie Google oder Bing eingesetzt werden. Diese Bots – darunter der Googlebot oder der BingBot – haben die Aufgabe, das Web systematisch nach neuen und aktualisierten Inhalten zu durchsuchen und diese zu indexieren. Suchmaschinen-Crawler folgen dabei bestimmten Regeln, die Website-Betreiber durch die robots.txt-Datei oder Meta-Tags beeinflussen können. Ihr Hauptziel ist es, eine möglichst vollständige und aktuelle Datenbank mit relevanten Webseiteninhalten für die jeweilige Suchmaschine zu erstellen, um Nutzern die besten Suchergebnisse zu liefern.

Fokussierte Crawler

Fokussierte Crawler (engl. Focused Crawlers) sind speziell darauf ausgelegt, sich nur auf bestimmte Themen oder Arten von Webseiten zu konzentrieren. Diese Art von Crawler wird beispielsweise von Branchenverzeichnissen, wissenschaftlichen Datenbanken oder themenspezifischen Suchmaschinen genutzt. Anstatt wahllos Links zu folgen, bewertet ein fokussierter Crawler den Inhalt einer Seite und entscheidet anhand vordefinierter Kriterien, ob sie für seine Datenbank relevant ist. Ein Beispiel hierfür sind medizinische Crawler, die gezielt nach Fachartikeln oder Studien im Gesundheitsbereich suchen.

SEO Tool Crawler

SEO Tool Crawler sind wiederum darauf spezialisiert, Suchergebnisse von Google, Bing oder Amazon zu analysieren. Diese Crawler werden von Anbietern wie Sistrix oder Semrush genutzt, um Rankings von Websites zu erfassen und diese zum Rank Tracking oder zur Wettbewerbsanalyse auszuwerten. Diese Crawler verstoßen in der Regel gegen die Nutzungsbedingungen der Suchmaschinenanbieter und werden daher getarnt und mit wechselnden IP-Adressen eingesetzt. Zuletzt hat Google beispielsweise seine Suchergebnisse auf JavaScript umgestellt, was auch dazu führte, dass einige SEO-Tools fehlerhafte oder unvollständige Daten erfassten. Zudem ist das Crawling von JavaScript-Inhalten aufwändiger und damit kostspieliger.

Preisvergleichs-Crawler

Ein weiteres Beispiel für spezialisierte Crawler sind Preisvergleichs-Crawler, die von E-Commerce-Plattformen oder Vergleichsportalen eingesetzt werden. Diese Bots durchsuchen Online-Shops, um Produktpreise, Verfügbarkeiten und Angebote zu sammeln und für Verbraucher vergleichbar zu machen. Dienste wie Idealo oder Google Shopping nutzen heutzutage jedoch vor allem API-Schnittstellen und Datenfeeds, um ihre Datenbanken mit aktuellen Preisen zu aktualisieren.

Social Media Crawler

Social Media Crawler sind darauf spezialisiert, Inhalte aus sozialen Netzwerken wie Facebook, Twitter, Instagram oder LinkedIn zu analysieren. Diese Crawler werden genutzt, um Trends zu erkennen, Erwähnungen von Marken oder Hashtags zu tracken und Nutzerdaten für Werbezwecke auszuwerten.

E-Mail-Harvester

Eine eher fragwürdige und oft als schädlich eingestufte Kategorie von Web Crawlern sind E-Mail-Harvester. Diese Bots sind darauf ausgelegt, E-Mail-Adressen von Webseiten und Foren zu extrahieren, um sie für Spam-Zwecke zu missbrauchen. Sie durchsuchen Webseiten gezielt nach typischen E-Mail-Formaten und speichern diese für den späteren Versand von unerwünschten Nachrichten. Website-Betreiber können sich gegen solche Crawler schützen, indem sie E-Mail-Adressen in verschlüsselter Form darstellen oder auf Kontaktformulare setzen.

Bedeutung von Web Crawlern für SEO

Web Crawler spielen eine zentrale Rolle in der Suchmaschinenoptimierung (SEO), da sie darüber entscheiden, ob und wie eine Webseite in den Index einer Suchmaschine aufgenommen wird. Ohne das regelmäßige Crawlen durch Bots wie den Googlebot könnte eine Webseite weder indexiert noch in den Suchergebnissen angezeigt werden. Daher ist es essentiell, eine Seite so zu optimieren, dass sie von Suchmaschinen-Crawlern effizient erfasst und interpretiert werden kann.

Indexierung und Auffindbarkeit

Die Hauptaufgabe eines Web Crawlers besteht darin, Webseiten zu analysieren und deren Inhalte in den Index der Suchmaschine aufzunehmen. Nur wenn eine Seite im Index enthalten ist, kann sie in den Suchergebnissen erscheinen. Dabei spielt eine gut strukturierte Website eine entscheidende Rolle:

- Klare URL-Struktur: Kurze, sprechende URLs erleichtern das Crawling.

- Optimierte interne Verlinkung: Crawler folgen Links auf einer Seite – je besser die interne Verlinkung, desto leichter finden sie alle wichtigen Inhalte.

- Vermeidung von nicht-crawlbaren Inhalten: Inhalte in Flash, JavaScript oder iFrames können für Crawler schwer oder gar nicht lesbar sein.

Um sicherzustellen, dass eine Seite indexiert wird, können Website-Betreiber die Google Search Console oder Bing Webmaster Tools nutzen, um Crawling-Statistiken einzusehen und gezielt Fehler zu beheben.

Crawl-Budget und dessen Optimierung

Jede Webseite hat ein sogenanntes Crawl-Budget, also eine begrenzte Anzahl von Seiten, die ein Suchmaschinen-Bot in einem bestimmten Zeitraum besucht. Suchmaschinen priorisieren das Crawling nach verschiedenen Kriterien, unter anderem:

- Domain-Autorität: Webseiten mit hoher Autorität und relevanten eingehenden Links werden bevorzugt gecrawlt.

- Aktualisierungshäufigkeit: Häufig aktualisierte Inhalte werden häufiger wieder besucht.

- Server-Performance: Langsame Ladezeiten oder Serverfehler können dazu führen, dass der Crawler weniger Seiten aufnimmt.

Eine schlecht strukturierte Website kann dazu führen, dass wichtige Seiten nicht indexiert werden, während unwichtige oder doppelte Inhalte das Crawl-Budget verbrauchen. Um das Crawling zu optimieren, sollten unnötige URLs vermieden oder durch robots.txt ausgeschlossen werden. Außerdem sollte Duplicate Content vermieden werden, zur Not per canonical-Tag. Letztlich kann auch die Indexierung durch Meta-Robots “noindex” ausgeschlossen werden. Dabei ist zu beachten, dass solche Seiten bestenfalls auch nicht verlinkt werden. Schnelle Ladezeiten (PageSpeed) und eine optimierte XML-Sitemap helfen ebenfalls, das Crawl-Budget effizient zu nutzen.

Steuerung des Crawl-Verhaltens

Da Web Crawler automatisierte Programme sind, die Webseiten eigenständig durchsuchen, ist es für Webseitenbetreiber entscheidend, deren Zugriff gezielt zu steuern. Nicht alle Inhalte sollen oder müssen von Suchmaschinen erfasst werden. Daher gibt es verschiedene Mechanismen, mit denen das Crawl-Verhalten beeinflusst werden kann.

robots.txt und Meta-Tags

Die robots.txt-Datei ist eine der wichtigsten Steuerungsmöglichkeiten für Web Crawler. Sie befindet sich im Root-Verzeichnis einer Website und gibt den Bots Anweisungen darüber, welche Bereiche gecrawlt werden dürfen und welche nicht. Typische Einträge in der robots.txt-Datei sind beispielsweise:

User-agent: *

Disallow: /private/

Dies bedeutet, dass alle Crawler den Ordner /private/ nicht durchsuchen dürfen. Allerdings handelt es sich hierbei nur um eine Richtlinie – schadhafte Crawler können sich darüber hinwegsetzen.

Alternativ können Meta-Tags in den HTML-Header einer Seite eingebunden werden, um die Indexierung zu steuern. Beispielsweise bewirkt folgender Tag, dass eine Seite nicht in den Index aufgenommen wird:

<meta name=”robots” content=”noindex, nofollow”>

Hiermit wird verhindert, dass die Seite in den Suchergebnissen erscheint, und es wird zudem unterbunden, dass Crawler den Links auf der Seite folgen. Dazu muss er die betroffene Seite jedoch crawlen können. Daher sollten sich Robots.txt und Meta-Robots-Angaben nicht überschneiden.

Crawl-Delay und dessen Gefahren

Ein weiteres Steuerungselement ist der Crawl-Delay-Parameter, der in der robots.txt angegeben werden kann. Er legt fest, wie viel Zeit ein Crawler zwischen zwei Anfragen an den Server warten soll. Dies soll verhindern, dass Crawler durch zu häufige Zugriffe die Performance beeinträchtigen. Ein Beispiel für einen Crawl-Delay-Befehl wäre:

User-agent: Googlebot

Crawl-delay: 2

Dies würde dem Googlebot mitteilen, dass er nach jeder Anfrage 2 Sekunden warten soll. Google selbst beachtet diesen Befehl in der robots.txt allerdings nicht. Unter Umständen kann das Verwenden von ‘Crawl-delay’ in der robots.txt dazu führen, dass Google die komplette Website nicht mehr crawlt. Daher ist ein Crawl-delay mit äußerster Vorsicht einzusetzen.

Schutz vor unerwünschtem Crawling und Spam-Bots

Da nicht alle Web Crawler erwünscht sind, müssen Websitebetreiber Maßnahmen ergreifen, um sich gegen bösartige Bots, Scraper und Spam-Crawler zu schützen. Diese Bots durchsuchen Webseiten oft in hoher Frequenz, um E-Mail-Adressen für Spam-Zwecke zu sammeln, Inhalte zu kopieren oder Serverressourcen zu belasten. Eine der einfachsten Methoden ist die robots.txt-Datei, in der unerwünschte Crawler durch Disallow-Regeln ausgeschlossen werden können. Allerdings halten sich schadhafte Bots häufig nicht an diese Vorgaben. Daher ist der Einsatz von CAPTCHAs und Honeypots sinnvoll, um automatisierte Zugriffe zu blockieren. Zusätzlich können Firewall-Regeln und serverseitige Schutzmechanismen (z. B. .htaccess-Sperren, IP-Blacklisting oder Rate Limiting) helfen, verdächtige Anfragen zu begrenzen. Moderne Web Application Firewalls (WAFs) bieten ebenfalls Schutz, indem sie verdächtige Crawling-Muster erkennen und blockieren. Um E-Mail-Adressen vor Crawlern zu verbergen, sollten sie nicht im Klartext auf der Website stehen, sondern beispielsweise in Bildern oder durch JavaScript verschleiert dargestellt werden. Eine Kombination aus diesen Maßnahmen hilft, unerwünschtes Crawling zu reduzieren und die Sicherheit der Website zu gewährleisten.

Crawler haben eine Schlüsselrolle im modernen Web

Web Crawler sind essentielle Werkzeuge für Suchmaschinen und zahlreiche andere digitale Anwendungen. Sie ermöglichen die Indexierung von Webseiten und sorgen dafür, dass Nutzer relevante Informationen in den Suchergebnissen finden. Ihre Funktionsweise basiert auf einem strukturierten Prozess aus Crawling, Linkverfolgung und Indexierung, wobei verschiedene Crawler-Typen für unterschiedliche Zwecke existieren. Damit eine Webseite optimal erfasst wird, sollten Website-Betreiber das Crawl-Verhalten gezielt steuern, um ihr Crawl-Budget effizient zu nutzen und unerwünschtes Crawling zu verhindern. Durch eine technische und inhaltliche Optimierung der eigenen Website kann die Sichtbarkeit in Suchmaschinen verbessert werden. Unerwünschtes Crawling für Spam-Zwecke sollte jedoch unterbunden werden.